Кодирование звуковой информации

Приемы и методы работы со звуковой информацией пришли в вычислительную технику наиболее поздно. К тому же, в отличие от числовых, текстовых и графических данных, у звукозаписей не было столь же длительной и проверенной истории кодирования. В итоге методы кодирования звуковой информации двоичным кодом далеки от стандартизации. Множество отдельных компаний разработали свои корпоративные стандарты, но если говорить обобщенно, то можно выделить два основных направления.

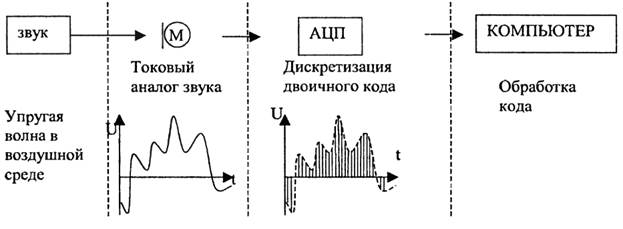

Звук - это упругая продольная волна в воздушной среде. Чтобы ее представить в виде, читаемом компьютером, необходимо выполнить определенные преобразования (рисунок 1.2). Прежде всего, звуковой сигнал преобразовывается в электрический аналог звука с помощью микрофона. Электрический аналог получается в непрерывной форме и не пригоден для обработки на цифровом компьютере. Чтобы перевести сигнал в цифровой код, надо пропустить его через аналого-цифровой преобразователь (АЦП). При воспроизведении происходит обратное преобразование - цифро-аналоговое (через ЦАП). Конструктивно АЦП и ЦАП находятся в звуковой карте компьютера.

Рисунок 1.2. Схема обработки звукового сигнала

Во время оцифровки сигнал дискретизируется по времени и по уровню (рисунок 1.3). Дискретизация по времени выполняется следующим образом: весь период времени Т разбивается на малые интервалы времени Dt точками t1, t2,...,tn. Предполагается, что в течение интервала Dt уровень сигнала изменяется незначительно и может с некоторым допущением считаться постоянным. Величина F=1/Dt называется частотой дискретизации. Она измеряется в герцах (Гц) - количество измерений в течение секунды.

Рисунок 1.3. Схема дискретизации звукового сигнала

Дискретизация по уровню называется квантованием. Область изменения сигнала от самого малого значения Xmin до самого большого значения Хmax разбивается на N равных промежутков (квантов) величиной

DХ = (Хmax - Xmin)/N.

Каждый квант связывается с его порядковым номером, т.е. целым числом, которое легко может быть представлено в двоичной системе счисления.

При кодировании звука возникают две задачи: как часто по времени надо измерять сигнал и с какой точностью надо измерять сигнал, чтобы получить при воспроизведении звук удовлетворительного качества.

Высокое качество воспроизведения получается в формате лазерного аудиодиска при следующих параметрах оцифровки: частота дискретизации - 44,1 кГц, квантование - 16 бит. Таким образом, 1 секунда стереозвука займет 2 байта. Качество звука при этом получается очень высоким.

Для телефонных переговоров удовлетворительное качество получается при частоте дискретизации 8 кГц и частоте квантования 256 уровней, т.е. 1 байт, при этом 1 секунда звуковой записи займет на диске 8000 байт.

Измерение информации

При кодировании любого типа информации важно определить, какое количество информации мы получаем при изучении какого-либо объекта? Изучение объекта связано с получением структуры виртуального объекта. Информация представляет собой определенную последовательность элементов, т.е. каждый новый символ, графическая точка или звук увеличивают количество информации. Для измерения количества информации, как и для измерения длины, массы и других мер измерения нужен эталон. В качестве такого эталона была выбрана единица измерения информации, получившая название «бит» (Bt).

Под битом мы будем понимать единицу измерения информации, представляющую собой выбор из двух равновозможных вариантов. Бит (от английского выражения "BInary digiT" - "двоичная цифра") является минимальной единицей информации. Бит представляет собой обозначение одного двоичного разряда, способного, в зависимости от сделанного выбора, принимать значение 0 или 1.

Как правило, принято работать не с отдельными битами, а сразу с группой бит. Для этого было введена дополнительная единица измерения информации, получившая название байт. В дальнейшем, под байтом мы будем понимать единицу измерения информации длиною в восемь бит. В одном байте можно закодировать значение одного символа из 256 возможных символов (256=28). Более крупными производными единицами информации являются килобайт (сокращенно обозначаемый КВ), равный 1024 байтам, мегабайт (сокращенно обозначаемый МВ), равный 1024 Кбайтам и т.д.

При определении понятия «количества информации» существуют различные подходы: вероятностный, объемный, содержательный, алфавитный.

Вероятностный подход

Формулу для вычисления количества информации, учитывающую неодинаковую вероятность событий, предложил К. Шеннон в 1948 году. Количественная зависимость между вероятностью события р и количеством информации в сообщении о нем x выражается формулой: x=log2(1/p). Качественную связь между вероятностью события и количеством информации в сообщении об этом событии можно выразить следующим образом – чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии.

Объемный подход

Объем информации, записанной двоичными знаками в памяти компьютера или на внешнем носителе информации, подсчитывается просто по числу требуемых для такой записи двоичных символов. При этом, в частности, невозможно нецелое число битов (в отличие от вероятностного подхода).

Между вероятностным и объемным количеством информации соотношение неоднозначное. Далеко не всякий текст, записанный двоичными символами, допускает измерение объема информации в вероятностном (кибернетическом) смысле, но заведомо допускает его в объемном. Далее, если некоторое сообщение допускает измеримость количества информации в обоих смыслах, то это количество не обязательно совпадает, при этом кибернетическое количество информации не может быть больше объемного.

Алфавитный подход

Алфавитный подход к измерению информации не связывает количество информации с содержательным сообщением. Рассмотрим этот подход на примере текста, написанного на каком-нибудь языке, например, на русском. Все множество используемых в языке символов будем называть алфавитом. Полное количество символов алфавита будем называть мощность алфавита.

Например, в алфавит мощностью N=256 символов можно поместить все необходимые символы: латинские и русские буквы, цифры, знаки арифметических операций, знаки препинания и т.д. Представим себе, что текст, состоящий из 256 символов, поступает последовательно, и в каждый момент времени может появиться любой из них. Тогда по формуле:

2i = 256, → i=8 (бит)

Таким образом, один символ алфавита мощностью 256 символов, “весит” 8 бит. Поскольку 8 бит – часто встречающаяся величина, ей присвоили свое название 1 байт:

Чтобы подсчитать количество информации на одной странице текста, необходимо: количество символов в строке умножить на количество строк на листе. Так, например, если взять страницу текста, содержащую 40 строк по 60 символов в каждой строке, то одна страница такого текста будет содержать 60*40=2400 (байт информации).

Информатика как наука

Термин «информатика» получил распространение с середины 80-х гг. прошлого века. Он состоит из корня inform - «информация» и суффикса ma lies - «наука о,..». Таким образом, информатика - это наука об информации. В англоязычных странах термин не прижился, информатика там называется Computer Science - наука о компьютерах.

Информатика — это наука о законах и методах измерения, хранения переработки и передачи информации с использованием средств вычислительной техники. Это комплексная наука об информации и информационных процессах, аппаратных и программных средствах информатизации, информационных и коммуникационных технологиях, реализуемых с помощью компьютеров.

Кроме того, это отрасль народного хозяйства, объединяющая совокупность предприятии разных форм хозяйствования, где занимаются производством компьютерной техники, программных продуктов, разработкой современных технологий переработки информации.

Наука появилась благодаря развитию компьютерной техники, базируется на ней и немыслима без нее.

Систематизация методов и приемов работы с аппаратными и программными средствами вычислительной техники составляет основную задачу информатики.

Изучение информатики позволяет:

- познать основы современных информационных технологий обработки информации, получить представление об информационных ресурсах общества;

- ознакомиться с современным состоянием и направлениями развития вычислительной техники и программных средств;

- овладеть приемами работы на персональном компьютере в качестве пользователя, уметь работать с программными средствами общего и специального назначения, использовать внешние носители информации для обмена данными между различными компьютерами, создавать копии и архивы данных и программ;

- овладеть навыками работы в сети Интернет.

Задачи информатики:

- производство современных ЭВМ и разработка современной архитектуры вычислительных систем;

- внедрение прогрессивных технологий обработка информации и технологий программирования;

- совершенствование управления интерфейсом вычислительных систем;

- разработка более совершенных способов защиты информации;

- развитие стандартизации;

- повышение уровня информационной культуры общества.

Информатика - молодая, быстро развивающаяся наука, связанная практически со всеми областями жизнедеятельности современного человека.

На рисунке 1.4 предложена структура информатики, как ее представляют себе многие современные авторы.

Рисунок 1.4 Структура информатики

Основными разделами информатики являются теоретическая информатика, изучающая вопросы теории информации, теории вычислительного эксперимента, алгоритмизации, программирования и искусственного интеллекта, а также прикладная информатика, предназначенная для обслуживания науки, техники, производства и других видов человеческой деятельности путём создания и передачи в общество информационных технологий. В информатике, под информационной технологией принято понимать совокупность методов и средств управления информационными процессами. Причем, компьютер является средством, позволяющим реализовать информационные технологии, качественно отличающиеся от прежних уровнем автоматизации и интеллектуализации информационных процессов.