Подходы к измерению и оценке ценности информации

В различных науках об информации предпринимались попытки ее измерения.

Первое научное осмысление понятия количество информации началось в теории связи. Были введены меры информации.

В 1924 г. Г. Найквист показал, что скорость передачи сигналов W по каналу связана с числом п различных кодовых символов зависимостью

W=klogn, (1.9)

где k – константа, определяемая скоростью передачи последовательных символов.

Он первым предложил логарифмическую меру информации.

В 1928 г. Р. Хартли [1] определил информацию сообщения как

H=mlogn, (1.10)

где т – количество символов в сообщении, а п – количество доступных для использования различных символов.

С точки зрения теории современной информации эта мера применима только тогда, когда символы выбираются независимо один от другого и выбор любого из символов равновероятен.

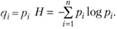

Наиболее полное развитие теории информации применительно к проблемам ее передачи было осуществлено в 40-е гг. XX в. К. Шенноном [2], который связал понятие информации с понятием энтропии и предложил следующую энтропийную меру:

(1.ll)

(1.ll)

где pi – вероятность того, будет или нет выбран г-й символ из полного набора в п символов, которые вырабатывает источник сообщений; величина Н (энтропия) измеряется в битах (от англ. binary digit – двоичная система).

Работы Шеннона и его последователей нашли широкое применение на практике – при оптимизации каналов связи, в системах обработки данных, при разработке электронно-вычислительной техники и т.п.

С развитием кибернетики и теории систем понятие информации развивалось.

Для оценки возможностей различных технических средств сбора, передачи и обработки информации были предложены: теоретико-игровой подход к оценке информации Р. Л. Стратоновича [3]. алгоритмический подход М. М. Бонгарда [4].

В дальнейшем информацию стали связывать не только с источником и приемником сигналов, но и с ее значением для потребителя.

Вначале имелись попытки применения рассмотренных выше мер и для оценки ценности социальной информации. Однако при этом возникают трудности доказательства адекватности таких мер.

Предпринимались также попытки создать семантическую теорию информации, из которых наиболее известной является концепция Р. Карнапа и И. Бар-Хиллела [5], базирующаяся на понятии логической вероятности как степени подтверждения гипотезы. В соответствии с этой концепцией наивысшей ценностью обладают гипотезы, подтвержденные достоверным знанием, экспериментом. В этом случае логическая информация приравнивается к единице, а семантическая – нулю. С уменьшением степени подтверждения гипотезы количество содержащейся в ней семантической информации увеличивается. Следует отметить, что при этом гипотезы формулируются па специальном языке, предложенном в рассматриваемой теории.

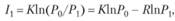

Развивая концепцию Карнапа – Бар-Хиллела, Л. Бриллюэн [6] предложил разновидность статистической меры для измерения семантической информации, основанную на измерении и уменьшении неопределенности (энтропии). Опираясь на второе начало термодинамики (принцип Карно), Л. Бриллюэн вводит для измерения информации следующую меру снижения энтропии:

(1.12)

(1.12)

где Р0 – число равновероятных исходов, возникновение которых априори считается равновероятным; при этом нет исходной информации о задаче, т.е. априорная информация I0 = 0; Р1 – число равновероятных исходов при наличии информации об измерениях в аналогичных, родственных ситуациях, и тогда информация, снижающая неопределенность равна I1.

Бриллюэн по аналогии с термодинамикой использовал натуральный логарифм, а для того чтобы выбрать систему единиц ввел коэффициент К, который для приведения к принятым к тому времени битам равен К = 1/ln2.

А. А. Харкевич [7] связал ценность информации с целью деятельности, предложив рассматривать энтропийную меру Шеннона как меру вероятности попадания в цель, т.е. как меру целесоответствия.

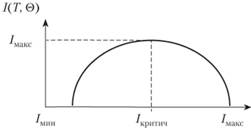

Ю. А. Шрейдер предложил построить теорию семантической информации на основе концепции разнообразия, а не концепции снятия неопределенности (рис. 1.5), и в частности, на основе учета такого свойства информации как зависимость получаемой информации от априорной информации [8].

Рис. 1.5. Зависимость информации от априорной информации

Опираясь на идею Н. Винера о том, что для понимания и использований информации получатель должен обладать определенным запасом знаний (в терминах математической лингвистики и теории формальных языков – тезаурусом Θ), Ю. А. Шрейдер определяет количество семантической информации, содержащейся в тексте Т, как изменение тезауруса ΘI(T,Θ).

Такой подход существенно отличается от концепции выбора при статистическом подходе, при котором предполагается, что получаемая информация тем больше, чем меньше априорных сведений содержится в приемнике информации. Напротив, по Шрейдеру, чем более сложную структуру имеет тезаурус, тем больше существует возможностей для изменений под воздействием одного и того же сообщения. Это хорошо согласуется с законом необходимого разнообразия У. Р. Эшби, согласно которому управляющая (осмысливающая, понимающая, принимающая решения) система должна обладать большим необходимым разнообразием (сложностью) по сравнению с разнообразием поступающей в нее информации от управляемой (понимаемой) системы (см. подробнее в гл. 3).

Предлагаемый Ю. А. Шрейдером подход согласуется также с наблюдениями за процессами обмена информацией: по мере роста наших знаний об изучаемом объекте растет и количество извлекаемой информации об этом объекте, однако в дальнейшем наступает насыщение и снижение количества получаемой информации. Динамику насыщения индивидуального тезауруса Ю. А. Шрейдер иллюстрирует некоторой условной зависимостью (рис. 1.5), характер которой зависит от конкретного потребителя информации или накапливающей информацию информационной системы.

Эта кривая характеризует одну из особенностей информации – зависимость получаемой информации от априорной информации. Для количественной оценки ценности семантической информации предлагались различные меры.

Так, в [14] предлагается мера для общечеловеческого тезауруса, под которым понимается совокупность понятий, вырабатываемых человечеством в процессе научного познания природы, общества и мышления, связанных друг с другом.

Процесс научного познания представляется как уточнение старых и формирование новых научных понятий, в выявлении и корректировке связей между понятиями, т.е. тезаурус трактуется как определенная структура, которая изменяется под воздействием новой информации в процессе познания и предлагается гипотетический подход, в соответствии с которым информация не одинаково зависит от сложности структуры.

Если под воздействием сообщения внутренняя структура общечеловеческого тезауруса 0 становится менее сложной, чем до этого сообщения, то в таком сообщении содержится больше информации, чем в сообщении, вызывающем усложнение структуры 0.

Этот вывод согласуется с опытом: известно, что крупные научные открытия в целом упрощают структуру знания – благодаря введению новых, более общих понятий, что и является следствием и проявлением свойства кумулятивности информации.

В [14] оговаривается гипотетичность предлагаемого подхода к оценке ценности информации в зависимости от структуры представления общечеловеческого тезауруса, и высказывается идея о необходимости поиска иных мер оценки ценности информации.

Для оценки удовлетворения информационных потребностей в теории научно-технической информации введены меры релевантности и пертинентности (см. гл. 6).

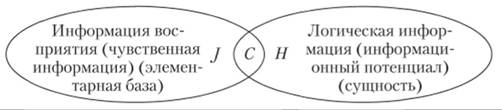

Затем, когда стали осознавать, что существуют различные виды информации, Е. К. Войшвилло [9] предложил различать информацию восприятия (знаки) и информацию-значение, смысловое ОГЛАВЛЕНИЕ для потребителя информации (означаемое знака).

В дальнейшем информацию стали рассматривать в нескольких аспектах с точки зрения наблюдателя (пользователя): прагматический – для достижения целей наблюдателя; семантический – с точки зрения смыслового содержания и правильности толкования; синтаксический (или материально-энергетический, знаковый, технологический) – с точки зрения техники передачи информации. При этом считали, что-либо наиболее общим является понятие прагматической информации, а семантический и синтаксический аспекты информации имеют подчиненное значение, либо эти аспекты можно считать уровнями существования информации, и стали вводить для разных уровней разные оценки (иногда с достаточно экзотическими названиями).

Так, в системе мер оценки экономической информации, изложенной в работах Ю. И. Черняка, предлагается различать несколько аспектов (уровней) представления и измерения экономической информации (с точки зрения се полезности для решения задачи, смысла или семантики текста, синтактики знакового отображения, морфологии образования знаков – слов и словосочетаний и передачи их по каналам связи) и для каждого уровня вводятся свои меры информации в терминах, принимаемых на этом уровне решений (прагма, сем, знак, или символ и т.п.) [10].

В теории информационного поля и ее дискретного варианта – информационного подхода к анализу систем А. А. Денисова [1, 8, 19], как было показано в параграфе 1.2, вводятся понятия чувственной J и логической Н (семантической и прагматической) информации, а информацией для потребителя является пересечение информации восприятия или чувственной информации и ее потенциала или логической информации, в результате чего формируется единое понятие – информационный смысл, информационная сложность (С), которое в частных случаях представляет собой декартово произведение У и Я (1.7).

Для конструктивного использования этих понятий А. А. Денисов ввел соответствующие детерминированные и вероятностные оценки.

Чувственная информация J вводится как мера отраженной в нашем сознании объективной реальности, элементной базы системы в виде

Ji = Ai/ΔAi, (1.13)

где Аi – общее количество каких-либо знаков, воспринимаемых измерительными приборами или нашими органами чувств; ΔAi – "квант", с точностью до которого нас интересует воспринимаемая информация, или разрешающая способность прибора.

Действительно, во-первых, J существенно зависит от разрешающей способности выбранного измерительного прибора и, во-вторых, определяется значимостью для нас измеряемой величины, т.е. целью измерений.

Так, наличие или отсутствие личного автомобиля у конкретного гражданина фиксируется с точностью до ΔА = 1 автомобиль, поскольку это обстоятельство для автолюбителя является весьма существенным. Напротив, сводные данные но производству автомобилей в стране приводятся с точностью до ΔА = 10 тыс. автомобилей, поскольку меньшее число автомобилей для страны в целом несущественно. Аналогично длину отрезка можно измерять с точностью до 1 м, до 1 дм, до 1 см, и соответственно получать разные значения J.

Даже при фиксированном ΔА информация, строго говоря, не является числом, поскольку в пределах более или менее ограниченных ΔА она может иметь любое значение.

Так, если вольтметр с разрешающей способностью в 1 В показывает 200 В, то истинное значение напряжения скорее всего лежит либо в диапазоне от 200 до 201 В, либо в диапазоне от 199 до 200 В; причем в общем случае оба диапазона равновероятны, так что можно ввести логарифмическую меру единицы информации ΔJ = -log2P = log20,5 = 1 бит, где р – вероятность наличия или отсутствия минимального значения информации.

С учетом соотношения (1.13) показания вольтметра дают нам J = 200 + + 1 бит информации, откуда следует, что информация не число, а величина, размытая в пределах 1 бита. Это значит, что в семантическом аспекте информация всегда есть J. Но в то же время, и в том же отношении она не есть J, т.е. не удовлетворяет логическому закону тождества и несет в себе, хотя и объективную, но относительную истину, в то время как число всегда несет в себе абсолютную истину. Так, показания вольтметра есть 200 В, когда стрелка остановилась на этом делении шкалы, но в то же время не 200 В, так как показания прибора всегда приближенны.

Таким образом, информация всегда несет в себе весьма значительный элемент субъективности и различна для разных людей при одном и том же А. Кроме того, даже при фиксированном ΔА информация, строго говоря, не является числом, поскольку в пределах более или менее ограниченных ΔА она может иметь любое значение.

Важно также оговорить, что два или несколько одинаковых измерительных прибора при измерении одной и той же величины в рамках их разрешающей способности могут дать различную информацию, но с одинаковой достоверностью.

Это значит, что информация не удовлетворяет логическому закону исключенного третьего, не допускающему существование нескольких противоречивых, но одинаково истинных величин, но зато удовлетворяет диалектическому закону единства и борьбы противоположностей.

Итак, информация – это понятие, не поддающееся анализу средствами формальной логики и требующее применения к нему диалектической логики, которая обеспечивает возможность анализа не только абсолютно, но и относительно истинных высказываний.

С этой точки зрения J аналогична высказываниям естественного языка, которые всегда носят размытый и относительно истинный характер. Однако ввиду дуальной природы J (число и не число) информация в отличие от вербальных форм поддается некоторым (не всем) математическим операциям.

Чувственная информация может измеряться и вероятностным способом:

Ji = -logpi, (1.14)

где pi – вероятность события.

Логическая информация (сущность) Н в отличие от J, всегда относящейся к конкретным объектам, или свойствам, характеризует целый класс однородных в определенном отношении объектов или свойств, являясь семантическим синтезом законов логики, правил функционирования системы и ее элементов, образующих функционал ее существования.

Согласно основному закону классической логики Аристотеля собственная сущность (суть) системы обратна объему понятия п о ней, т.е.

H=J/n. (1.15)

Объем понятия зависит от аспекта рассмотрения системы (элемента) и обычно предполагает родовую их принадлежность.

Например, объемом понятия "производственное предприятие" является общее количество вообще всех производственных предприятий в городе (области, стране), а объем понятия "это производственное предприятие" равен единице.

Если система характеризуется множеством своих состояний, подобно рабочей неделе, которая состоит из понедельника, вторника, среды и т.д., то это множество и составляет объем понятия "неделя", который равен 7, а сущность трех дней недели H = 3/7.

Способ опосредования (усреднения) J может быть и иным, для чего вводится параметр у, который может выбирать постановщик задачи. Тогда:

(1.16)

(1.16)

где Ji– результаты измерения Аi согласно (1.13); п – объем понятия, т.е. число охватываемых понятием объектов; γ – параметр логики усреднения, при различных значениях которого получаются различные выражения для определения Я, приведенные в табл. 1.1 (в таблице П – знак произведения).

Таблица 1.1

Основные способы измерения J и Н по А. А. Денисову

|

|

|||

|

Детерминированный способ измерения |

где A j – значение измеряемой величины; AAj – "квант", с точностью до которго Л ПР интересует воспринимаемая информация (единица измерения, разрешающая способность прибора) |

где Ji – результаты измерения А{, п – объем понятия об охватываемых измерением объектах; у – параметр усреднения |

При у = 1 получим среднее арифметическое

При у = 0 получим среднее геометрическое

При у = -1 – среднее гармоническое |

|

Вероятностный способ измерения |

где Pi – вероятность события. В случае использования информации для достижения цели Pi называют вероятностью недостижения цели или степенью нецелесоответствия |

где q1, – вероятность использования элемента информации. При При равновероятном выборе элемента

Для прагматической информации

где |

|

Отметим, что как вербальная форма основного закона логики, гак и символическая форма (1.15), являются размытыми, поскольку под обратной зависимостью подразумеваются различные конкретные формы, а соотношение (1.15), хотя и имеет форму обратной пропорциональности, но в силу размытости J также означает определенный диапазон конкретных зависимостей. Вообще же количественные значения H и J в статике совпадают (так как п = 1), однако в отличие от J, сущность понятия Я не может быть объектом непосредственно чувственного восприятия, а является результатом логического осмысления, что отражается в трактовке п.

В частности, п можно рассматривать и как объем (емкость) памяти, занятой сведениями об отражаемом понятии, поскольку понятие формируется на основе сведений, содержащихся в нашей памяти (или в памяти ЭВМ).

Обратим также внимание на тот факт, что рассматриваемый закон в основе своей непрерывен (в силу обратной пропорциональности п) и его действие должно распространяться на непрерывную (многозначную) логику.

Логическую информацию H можно определить не только через параметры синтезирующей ее системы (человека, автоматизированной информационной системы).

Если учесть, что, как было отмечено ранее, H характеризует не единичный объект, а класс однородных в определенном смысле объектов или свойств, то H можно определить через плотность вероятности f(Ji) того, что J имеет значение Ji:

(1.17)

(1.17)

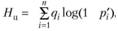

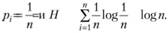

В частном случае вместо плотности вероятности можно охарактеризовать класс однородных объектов просто вероятностью qi и представить Ji в логарифмической форме; тогда получим

(1.17,а)

(1.17,а)

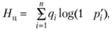

Значения qi и рi могут быть не равны, но возможны ситуации, когда qi = рi, что имеет место в формуле Шеннона

(1.17,6)

(1.17,6)

Прагматическая (целевая) информация Нц описывается моделью, аналогичной (1.17, б), только для практических приложений удобнее заменить вероятность недостижения цели pi на сопряженную (1 - ):

):

(17, в)

(17, в)

где  – вероятность достижения цели; qi – вероятность того, что оцениваемая компонента будет использована для достижения цели.

– вероятность достижения цели; qi – вероятность того, что оцениваемая компонента будет использована для достижения цели.

Таким образом, из вышесказанного следует, что J и H могут измеряться различными способами – детерминирование и с помощью вероятностных характеристик.

Поскольку в некоторых приложениях могут быть использованы одновременно обе формы представления информационных характеристик: и детерминированная, и вероятностная, а также переход от одной формы к другой, то удобно пользоваться сопоставительной табл. 1.1, в которой приведены основные способы измерения J и H.

Следует отметить особенности вероятностных характеристик, используемых в излагаемом подходе. В частном случае р, может быть статистической вероятностью, определяемой на основе репрезентативной выборки, подчиняющейся той или иной статистической закономерности. Однако далеко не всегда может быть строго определено вероятностное пространство. В этом случае можно использовать понятие размытой вероятности в смысле Заде.

В общем случае в теории А. А. Денисова вероятность достижения цели  и вероятность использования оцениваемой компоненты (свойства) при принятии решения qi могут иметь более широкую трактовку и использоваться не в строгом смысле с точки зрения теории вероятностей, справедливой для стохастических, повторяющихся явлений, а характеризовать единичные явления, события, когда рi выступает как степень целесоответствия.

и вероятность использования оцениваемой компоненты (свойства) при принятии решения qi могут иметь более широкую трактовку и использоваться не в строгом смысле с точки зрения теории вероятностей, справедливой для стохастических, повторяющихся явлений, а характеризовать единичные явления, события, когда рi выступает как степень целесоответствия.

По аналогии с предшествующими исследованиями Р. Хартли, К. Шеннона, А. А. Харкевича, в качестве единицы измерения информации принята единица, основанная на двоичном логарифме, дающая в качестве минимальной единицы информации величину 1 бит.

Эго удобно и по следующим соображениям. Для того чтобы (14) давало информацию в битах, необходимо понимать, что априорная принадлежность каждого деления шкалы измерительного прибора измеряемой величины составляет 0,5. Тогда, поскольку шкала представляет последовательное соединение делений, совместная вероятность того, что J из них принадлежат измеряемой величине составляет р=2-j откуда получается J=-log2p, которая вместе с тем является решением уравнения:

(1.18)

(1.18)

В то же время, в принципе могут быть приняты и иные меры сжатия информационной шкалы – восьмеричные логарифмы – байты (уже нашедшие применение для оценки объемов информации в вычислительной технике) или даже, не применяющиеся пока – десятичные логарифмы (единицу можно назвать, например, "дек" ), натуральные логарифмы ("непер") и т.п.

Существуют и другие меры количества информации, учитывающие процесс ее передачи и изменение вероятности появления сообщения от априорного значения р(х) на входе канала передачи информации к апостериорному значению р (х/у) на выходе канала, связанные с искажением информации в канале, т.е. основанные на условной вероятности [10, с. 16–21].

– вероятность достижения цели, степень целесоответствия

– вероятность достижения цели, степень целесоответствия